视效技术的升级换代一向很快,“实时”技术就给影视行业带来了翻天覆地的变化。“实时”技术通过游戏引擎和GPU(图形处理器)完成实时渲染,已经被广泛用于虚拟制作的方方面面,比如预览、布景、实时动捕、模拟摄影、现场合成、镜头内特效(In Camera VFX)和最终成像渲染等。实时制作的优势在于:1.演员和工作人员能即时或更快地得到反馈;2.与后期制作相比,前期制作和现场拍摄的占比越来越大。

在实时技术上运用比较成功的作品,去年有《狮子王》和《曼达洛人》,而现在基本上大大小小的视效作品中都采用了实时技术。以下是一些与实时技术相关公司的采访,一起探讨实时技术对影视行业未来的影响。

Epic Games研发了虚幻引擎,也因此成为引领实时技术的先驱之一。Epic Games最近发表的样片中展示了实时技术的镜头内特效的效果——演员骑着摩托车,背后是一组LED墙板,墙上的背景图与现场表演无缝衔接,而且还可以实时修改。

Epic Games技术总监表示:“利用LED墙拍摄这种方式会极大地改变电影制作,比如镜头内最终成像、优化幕墙的光照、实时改变3D现场和演员的光照、现场修改3D场景、演员表演时可以直接看到场景、快速换景,在同一场景切换时间段、在VR侦查,充分在现场使用游戏装置和模拟元素等等。

Epic Games 产品经理在2019 SIGGRAPH 上阐述了LED显示屏技术在电影拍摄中的运用视频来源:虚拟引擎公众号

“电影制作人都很青睐实时技术,因为这样可以更准确地预测场景、了解制作要求。比如借助VR提前探查场景,实时与导演和摄影指导沟通协调。在虚拟拍摄中,摄影指导对调光范围广,操作快也很喜欢。实时技术可以让视效团队工作流程比以往更高效。”

渲染通道

Unity Technologies公司凭借Unity游戏引擎,成为实时渲染和虚拟制作的另一巨头。Unity和UE一样,无论是开发游戏还是特效拍摄,都越来越受欢迎。Unity的主要功能是可编程渲染通道(Scriptable Render Pipeline),可以使开发人员能更轻松地访问工作流程,直接在引擎里调整和优化渲染的方法。

Unity Technologies图形处理副总监介绍说:“在可编程渲染通道(SRP)中,开发人员可以自行选择算法,充分利用公司提供的两个预方案,将其作为模板构建自己的算法,或者从头开始创建完全定制的渲染方案。这样高精度的细节处理可以让你在考虑图形要求和发布平台等各种因素之后,仍然能选择最佳方案。”

之前构建离线渲染器的公司也在发展实时渲染技术,比如V-Ray的制造商Chaos Group就正在研发实时光线追踪的应用程序(Project Lavina)——让用户在光线追踪环境中能实时看到V-Ray场景。

Chaos Group全球创意总监介绍说:“我们从一开始就想研发一个实时光线追踪器,所以我们最关注的就是速度,而NVIDIA的新卡和硬件确实能有效地提高速度。”“想象一下,如果3D应用程序里的场景能做到光线实时追踪,就不用来回切换画面了,只用改变需要的着色器、素材或光照,就可以即时看到效果。”

像《阿凡达》、《头号玩家》、《狮子王》这样运用大量虚拟制作技术的电影,大都采用了专门探查场景、模拟摄影和VR协作的实时工具和流程。Glassbox在内的很多工作室就为电影制作人提供了很多“开箱即用”的虚拟制片方案。

如果将Glassbox的DragonFly和BeeHive工具和内容构建软件(如Unreal,Unity和Maya)相结合,就可以实现在虚拟场景上进行虚拟表演,比如可以实时看到CG生成的生物飞过幻想世界,而且还可以促进虚拟艺术部门和虚拟场景之间的协作。Glassbox Technologies的联合创始人玛丽安娜(Mariana)说:“虽然之前就有虚拟拍摄技术,但如果在技术和人力方面投入不够,工作室就无法在视效、游戏和VR开发中高效开展实时工作。”“不过DragonFly和BeeHive两个工具的出现能有效解决这个问题——我们根据最新的VR和游戏引擎技术打造了一个不依赖平台的生态系统,让工作室可以在不考虑规模和预算的前提下,能更改电影和内容制作。

ThruView系统也许是实时视效最好的工具之一。这一系列工具可以实现在现场进行实时预览,用预渲染的CG,在摄影机内实时显示和捕捉提前合成的实景素材。“对于驾驶、飞行、飞机、火车和汽车或延伸这些特定的场景来说,ThruView都是非常理想的工具。与绿幕相比,它可以优化景深、让道具发光、还可以在合成图像时提供实时反馈。你只要有这套满足现场需求的工具,可以不用让下游人员提前两周作出方案,也可以不依赖其他人,就可以实时制作出你想要的画面。”“在最近上映的一部电影中,有个火车镜头让人印象很深刻。为了制作这个镜头,Nicholson的团队用了10个摄影机拍摄了火车移动的真实镜头,提取了14小时长的底片(200TB),并做好色彩校正为实拍火车车厢作准备。在现场做了一个8K的背景屏,用10个服务器支撑40个4K屏幕,对准火车(150英尺长)的每个车窗口,实时设置还可以在火车穿过隧道时进行现场调光。”“ThruView系统提供了传统的绿幕合成的全部功能和创新工具,最重要的是可以实现实时。ThruView很注重成片像素和现场的拍摄,如果需要的话,只需操作几个按键,就可以进行后期制作,完成至少80%的工作,而且不用再备份、重头再来。

实时中的表演

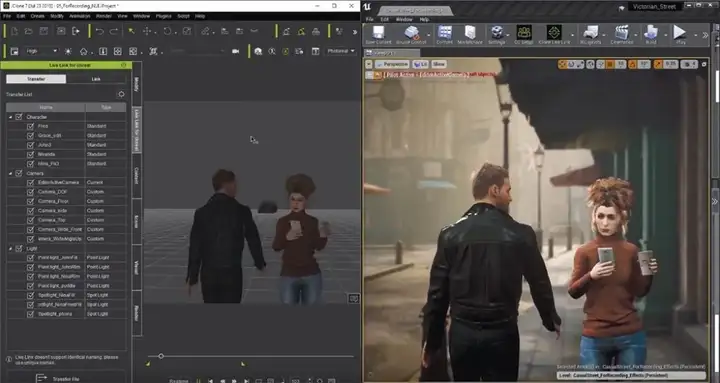

实时技术可以让动画师和视效艺术家或者演员直接进入到角色中,这样的话,就可以在保证高真度的前提下,以很快的速度捕捉和创建角色。例如,Reallusion的iClone通过Motion Live插件就可以做到这些。Motion Live插件汇总了一系列业内(包括Xsens、Noitom、Rokoko、OptiTrack、Qualisys和ManusVR的工具)捕捉收集的动作数据流。然后在iClone中选择一个角色,给Motion Live指定面部、肢体或手部识别设备,比如说iPhone,然后用LiveFace iPhone这个应用程序传输数据,可以筛选这些数据,或者同时用到实时全身捕捉。”这还只是iClone创建角色和制作动画庞大功能的一小部分,现在还可以通过插件iClone Unreal Live Link连接到UE,Reallusion从Character Creator 3就开始研发这个功能,希望可以完成动画的自定义变形和设计角色。通常需要先用iClone制作角色动画,再把角色、动画、拍摄和光照直接导入UE,虽然用FBX也可以完成导入,但是借助Live Link插件可以实时处理更多内容。

iClone的Unreal Live Link界面的截图

虽然实时技术仍处于研发阶段,在2019年SIGGRAPHNVIDIA公司研发的GauGAN在实时领域代表了这个技术的发展。用户可以在GauGAN里简单地绘制场景的轮廓,然后通过英伟达神经网络平台就可以看到处理好的美丽风景。现在NVIDIA已经成为图形卡的主要提供商,对实时渲染和机器学习的研究都作出了重大贡献。

NVIDIA首席科研家刘明宇说:“GauGAN试图模仿人类的想象能力,输入图像分割模型(即场景的语言描述),就能输出像照片一样真实的图像。GauGAN输入了大量的风景图库和对应的图像分割模型,几周后GauGAN就可以抓到两者的关联。”

实时虚拟人

逼真的虚拟人在电影和电视剧中引起轰动的同时,实时生成的CG角色也开始抓人眼球。数字王国(Digital Domain)凭借CG虚拟人的经验和内部的专业团队Digital Human Group也开始研发实时虚拟人。数字王国的软件研发高级总监道格·罗布尔(Doug Roble)在2019TED演讲上不仅展示了他的实时“化身”,还介绍了如何制作虚拟人。他说:“实时引擎Unreal制作逼真虚拟人的能力简直令人震惊。我们用高分辨率的演员动捕设备制作同样高分辨率的模型、肌理、位移和发型来生成实时虚拟人的外观,在确保在不失真的前提下,我们还会做一些优化。”

出席TED演讲时,他身穿Xsens惯性动作捕捉服、Manus手套和头戴式摄像头,这些设备可以把捕捉到的动作导入Ikinema,在Unreal中生成虚拟人“数字道格”的模型,然后就可以在大屏幕上看到道格的实时“化身”。除此之外,机器学习技术还能实时复制道格的面部表情,让“数字道格”更真实生动。这个演示只用了1/6秒就可以计算、传输和重新渲染人的面部轮廓、手指运动和面部血流!